Dans le domaine de la sécurité TI, il y a eu un changement majeur et c’est la généralisation des intelligences artificielles en grand public. Ces derniers, jusqu’à tout récemment, étaient des logiciels qui demandaient une expertise pour être exploités et ne pouvaient faire que des tâches précises (amélioration des images dans les logiciels de photomontage, correction syntaxique, proposition de mot dans les logiciels de ChatGPT). Cependant, avec l’arrivé de ChatGPT, la recherche d’information, production de documents, créations diverses et, etc., changent pour le meilleur et pour le pire.

Ce que je veux dire surtout pour le pire, et ce dans un contexte criminalistique, c’est que le logiciel ChatGPT et ses semblables, étant un outil puissant répondant d’une manière précise à des demandes de plus en plus techniques, peuvent aider à commettre des crimes. Que ce soit par la création de virus, ou l’obtention de savoir. Pour ceci je me réfère à cet article : https://www.science-et-vie.com/magazines/technologie/intelligence-artificielle-chatgpt-virus-malware-indetectable-102671.html. Du point vu criminalistique, lors du recueillement de la preuve, du fait de l’aspect même de la technologie ainsi que de sa manière de gérer les données. Il risque d’avoir des soucis, dont la reproductibilité de preuve, ou l’accès à l’information.

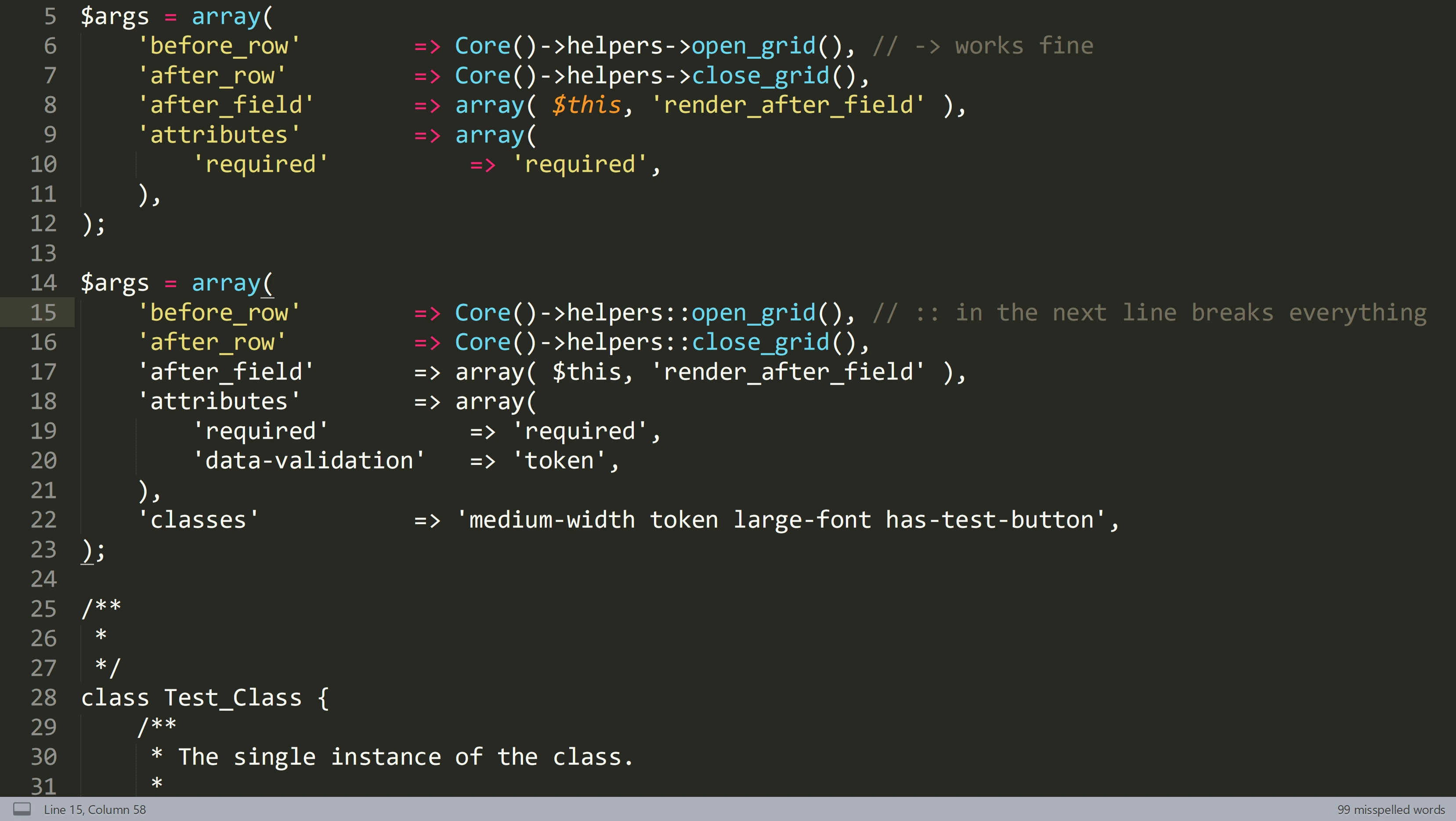

Pour le premier, ce que je veux dire par reproductibilité de preuve c'est que dans une enquête, la chaîne de la preuve est importante pour savoir la provenance et améliorer notre vision de cette dernière. Avec une IA, même si on sait qu'elle a produit la preuve, on ne peut à partir d'une même entrée générer à 100% cettedite preuve. Comme exercice, je travaille avec ChatGPT pour trouver des titres et même en demandait 3 fois cette question: "Donne-moi 5 titres d'articles basés sur ce texte (celle que vous lisez)", j'ai eu des choix différents. Ce qui est bien pour moi, mais pas pour une enquête. Ceci vient même de la conception d’une IA générative telle que ChatGPT. Ce sont des produits statistiques en constantes évolutions, ce qui fait en sorte qu'ils changent en tout temps. Le produit final généré par ces derniers n’étant pas fait par un programme précis, mais une conversation, a de grande chance de rendre la reproduction de la preuve difficile à reproduire. Même si je concède que les questions simples sont faciles à être reproduites telles que : « la couleur du soleil » ou « le nom du premier ministre du Canada ». Cependant, dans les demandes longues et qui demandes plusieurs commandes (et le tout va s’empirer avec les IA qui s’auto-entraînent), le fait d'avoir la probabilité d'avoir 2 fois la même réponse aux mêmes questions est presque impossible. Quoiqu’un système d’archivage puisse être mis dans certains cas, mais du fait de la deuxième partie on n’aura jamais la preuve au complet. Pour ceci je me base à cet article et au dernier paragraphe.

Le second étant l’accès aux données brutes pour voir le chemin qui a mené à l'action ou comprendre le code source qui permet l'action précise. Une IA a pour base de connaissances un modèle qui est entraîné. Du point de vue donné, pour nous c’est plus un ensemble de matrices mathématique, représentant et générant des fonctions mathématiques tel qu’un fichier Excel sans annotation. Pour le lire, il y a juste l'IA qui peut le lire. Ceci revient à essayer d’accéder à un cerveau biologique du fait de sa conception inspirée. Alors, pour les experts, dans tous les domaines Ti, on peut juste contrôler l’entrant et voir le sortant pour créer d’autre entrant ce qui rend le fonctionnement opaque ref. Actuellement, il n’y a pas de manières de modifier les modèles manuellement, et ce même pour les concepteurs. Un exemple pour les IA grands publics est le nouveau BING de Microsoft. Chaque requête à ce produit vient avec une suite d’instruction dictée comme des demandes humaines et qui sont ajoutées dans un simple copier-coller REF.

En lien avec le second, j'ajouterais un autre défi et c'est l'analyse de large volume de données. Car même si pour les modèles assez basiques peuvent rouler dans nos compagnons de tous les jours comme les cellulaires. Les modèles évolués sont assez lourds et demandent un matériel assez récent. Même s'il y a des modèles libres de sources comme GPT4ALL qui permettent d'avoir sur son ordinateur une version locale. Cette dernière va prendre assez de temps pour un résultat moins fin que ceux en ligne qui utilise des grappes de serveurs. Même si, les dans un avenir à moyen terme et l'évolution de nos approches va permettre de mieux analyser les volumes de données. Il va falloir, surement, utiliser des outils à base d'IA tels que le data-mining pour nous aider dans les enquêtes.

Pour conclure, avec ces éléments, ils peuvent avoir des pistes de solutions tels que le recueillement de données lors de la saisie, l’enregistrement des sessions conversationnelles avec les logicielles, la sauvegarde de la mémoire et l'exploration de données pour analyser le tout. Les 3 premiers sont plus ou moins mis en place pour les modèles accessibles à tous, mais il y a une généralisation des modèles personnels en ligne sur des sites de distributions tels que GitHub qui peut ne pas avoir ces prises d'informations. Pour le second, il va devoir avoir un travail entre les gouvernements, cours et compagnie pour avoir des accès facilités et beaucoup de travail pour avoir des solutions d'analyses performantes. L'IA, dans son principe d'autoformations et d'apprentissages, rend l'accès à ses entrailles très compliqué pour l'instant, mais pas tout à fait impossible. Alors, pour les prochaines années, ceci reste un beau défi.

Section commentaires

Autres articles dans les mêmes sujets

Les pièges à éviter pour les enquêteurs lors d'une investigation sur les cybercriminels en cas de cyberincident