Ceci est frais de mon cours de ce soir!

Quand, on publie de quoi en ligne, on veut que le tout marche et on met le max d'informations pour qu'on soit bien référencé. Mais, on oublie certains détails. Ceux que je parle sont les fichiers qu'on donne à Google et autres moteurs de recherches. Les fameux robot.txt et sitemap.xml. D'une apparence toute simple, ils peuvent en dire plus que le nécessaire, car pirater ce n'est pas taper comme un fou des commandes Linux, mais chercher le détail qui tue.

Pour aller plus en profondeur, ces fichiers servent essentiellement pour le référencement, le premier permet de dire au robot qui parcourt le site où aller et/ou ne pas aller et le second permet de faire une carte du site.

Cependant, pour robot.txt, le détail qui tue, c'est la partie ou ne pas aller, car ceci révèle les chemins qu'on ne veut pas être référencé comme l'administration du site, un sous-dossier pour la version test ou toute autres chose qu'on souhaite garder secrètes.

Pour le second, c'est un peu la même raison, mais vu que c'est un fichier qu'on programme, c'est plus dans les erreurs de programmation qui va générer un fichier trop généreux qu'on s'attend à avoir. Car, comme son nom le dit, c'est la carte du site.

Pour sécuriser, c'est un peu plus compliqué que le déplacé, dans un autre répertoire, ce qu'on doit faire c'est de filtrer les utilisateurs. En soi, de mon côté, la meilleure solution c'est de mettre dans le serveur http ou directement dans la gestion des routes aux niveaux du framework du site une règle qui autorise seulement les robots connus pour la consultation et le reste de mettre un code d'erreur 404.

Pour plus d'informations:

#pour

Section commentaires

Autres articles dans les mêmes sujets

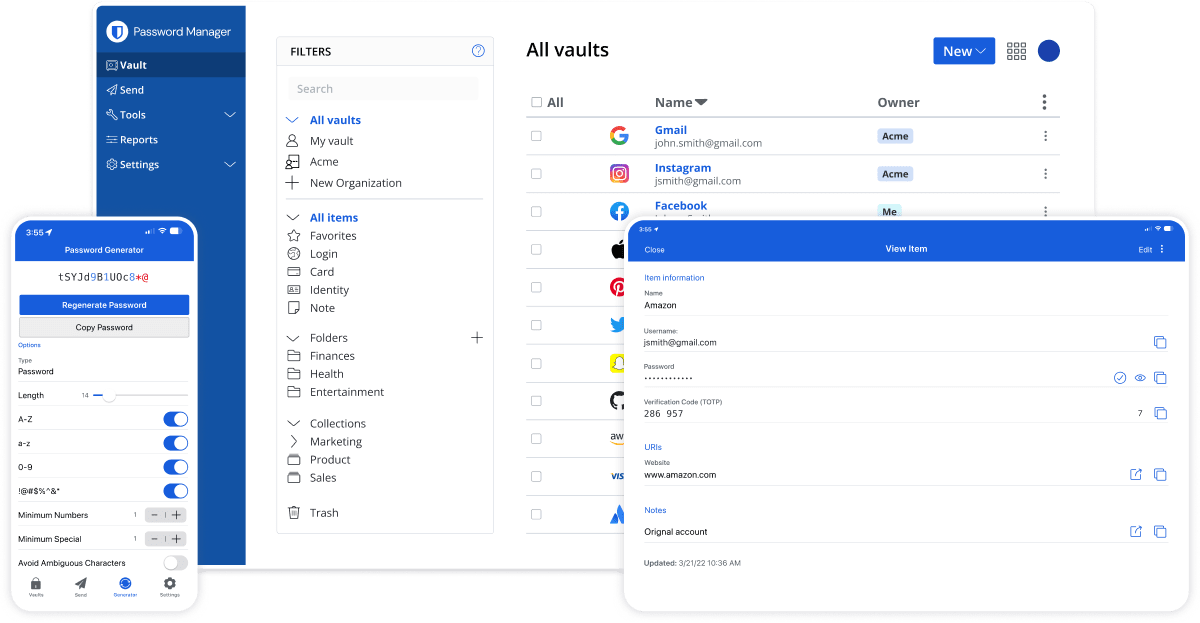

Les gestionnaire de mots de passes.